DeepSeek: De Chinese AI-concurent die de industrie ontwricht

op

De AI-industrie is in rep en roer door de opkomst van het Chinese AI bedrijf DeepSeek (deze link werkt mogelijk niet wanneer je deze bezoekt, omdat ze momenteel kampen met een cyberaanval), dat een krachtig large language model (LLM) heeft ontwikkeld tegen een fractie van de kosten van Westerse tegenhangers. Met zijn nieuwste open-source release onder de MIT licentie, schudt DeepSeek het hele AI-landschap op zijn grondvesten, lokt reacties uit de markt uit en wakkert speculaties over de toekomst van AI-competitie aan.

DeepSeek: AI-technologie voor een koopje?

DeepSeek's vlaggenschip DeepSeek-R1 model kostte naar verluidt slechts $5,6 miljoen om te trainen, een fractie van de $100 miljoen+ budgetten van AI giganten zoals OpenAI, Google en Anthropic. Desondanks behaalt DeepSeek-R1 benchmarkresultaten die vergelijkbaar zijn met ChatGPT, terwijl het aanzienlijk minder kost om te laten functioneren.

In tegenstelling tot veel AI-modellen die vertrouwen op brute kracht berekeningen, heeft DeepSeek de training geoptimaliseerd door zich te richten op reinforcement learning en stapsgewijs redeneren, waardoor de nauwkeurigheid wordt verbeterd zonder overmatige rekenkracht. Het model splitst complexe problemen op in kleinere stappen, vergelijkbaar met hoe een lange deling eenvoudiger is als deze op papier wordt uitgewerkt.

Hardware-efficiëntie en lokale implementatie

Hoewel Amerikaanse exportbeperkingen China hebben verhinderd om toegang te krijgen tot de beste AI-chips van Nvidia (zoals de H200 en toekomstige B100), heeft DeepSeek deze beperkingen omzeild. In plaats van te vertrouwen op ultra-hoogwaardige hardware, trainde het bedrijf zijn model met behulp van 2.048 Nvidia H800 GPU's, die minder krachtig zijn dan afgeschermde H100's, maar nog steeds efficiënt voor AI-workloads. De H800 is “een aangepaste versie van de H100 die specifiek op de Chinese markt wordt verkocht vanwege exportregels”, aldus NVIDIA.

Om het potentieel van DeepSeek nog verder te vergroten, heeft DeepSeek verschillende versies van zijn model uitgebracht, waardoor het op consumentenhardware kan draaien. Eén zo'n versie werd onlangs lokaal gedemonstreerd op een Raspberry Pi met een SSD en een Hailo-module, waarbij 200 tokens per seconde werden bereikt. Kijk hoe Jeff Geerling dit voor elkaar krijgt:

De H800's zijn minder krachtig dan de afgeschermde H100's, maar nog steeds geschikt voor grootschalige AI-training. De noodzaak om deze goedkopere AI-chips te gebruiken dwingt Chinese onderzoekers om hun trainingsmethoden te optimaliseren en meer te vertrouwen op software-efficiëntie in plaats van brute rekenkracht. Desondanks is DeepSeek erin geslaagd om concurrerende AI-prestaties te leveren, wat bewijst dat strategisch algoritmeontwerp hardwarebeperkingen kan compenseren.

Reactie op de markt en gevolgen voor de industrie

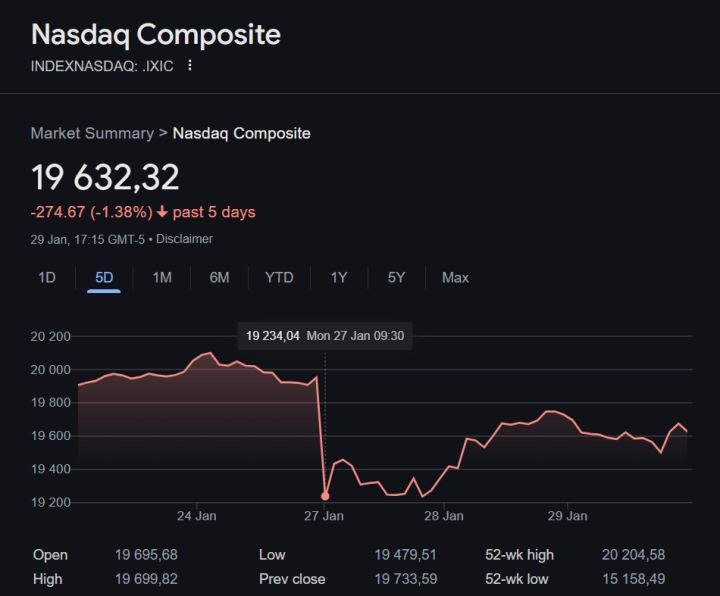

De snelle opkomst van DeepSeek heeft al voor beroering gezorgd op de wereldwijde markten. Na de lancering kelderde de Nasdaq Composite index in één dag met bijna 3%, waarbij tech-aandelen - vooral die van AI-intensieve bedrijven zoals Nvidia, Microsoft en Alphabet - verliezen leden. De AI-industrie wordt nu geconfronteerd met de realiteit van hoogwaardige, goedkope open-source concurrentie die de verdienmodellen van merkgebonden AI-diensten kan uitdagen.

Een verschuiving naar Edge AI?

Een van de meest interessante aspecten van de aanpak van DeepSeek is de potentiële impact op IoT en edge computing. Met lichtgewicht AI-modellen die kunnen draaien op hardware met een laag stroomverbruik maakt DeepSeek de weg vrij voor realtime, lokale AI-verwerking in sectoren als energiebeheer, automatisering en embedded systemen. Dit zou de afhankelijkheid van cloudgebaseerde AI-diensten kunnen verminderen, de operationele kosten verlagen en de privacy verbeteren door de gegevensverwerking op het apparaat te houden.

De toekomst van AI-competitie

Nu DeepSeek bewijst dat high-end AI-modellen kunnen worden getraind voor een fractie van de traditionele kosten, zijn de bredere consequenties duidelijk:

- Open-source AI wordt steeds beter concurrerend.

- Efficiëntie en algoritmische verbeteringen kunnen belangrijker zijn dan pure rekenkracht.

- Het Chinese AI-ecosysteem ontwikkelt zich snel, ondanks hardwarebeperkingen.

Of DeepSeek de markt blijft ontwrichten valt nog te bezien, maar één ding is zeker: De AI-race is zojuist een stuk interessanter geworden.

Vertaling: Hans Adams

Discussie (0 opmerking(en))